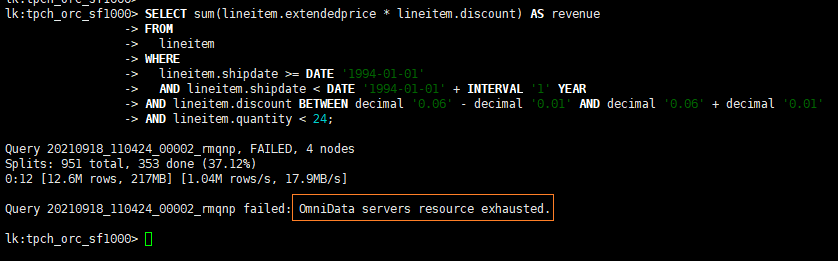

TPCH SQL6异常报错问题

现象描述:

TPCH SQL6异常报错问题。

解决方法:

此异常是因为OmniData算子下推配置项中max.task.queue.size的缺省值为存储节点的CPU数量的4倍,可以通过修改此值增加队列深度,解决此问题。

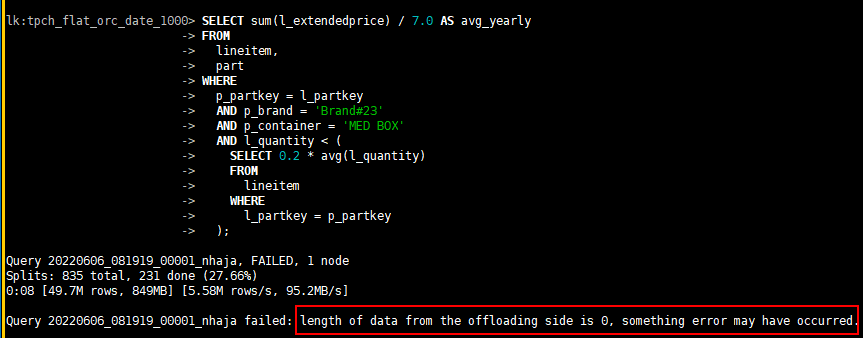

TPCH SQL17异常报错问题

现象描述:

TPCH SQL17异常报错问题。

解决方法:

此异常是因为OmniData算子下推配置项中task.timeout.period的缺省值为120000ms(2分钟),可以通过修改此值增加任务处理最大超时时间,解决此问题。

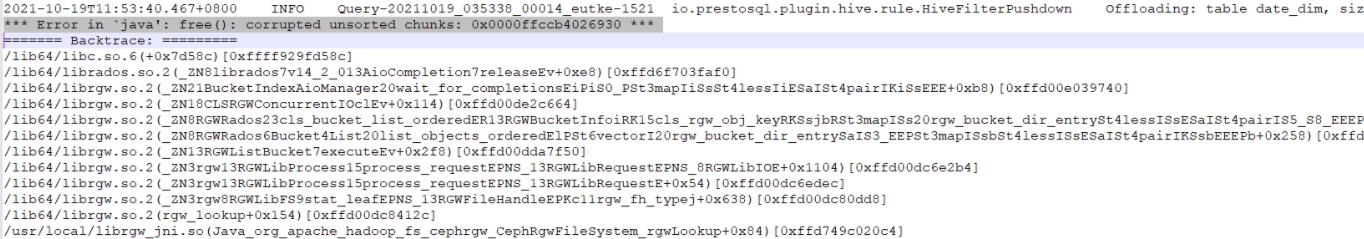

TPCDS SQL3异常报错问题

现象描述:

TPCDS SQL3执行导致引擎coredump。

解决方法:

此异常定位为Ceph社区固有问题,待社区解决。

通过在Ceph配置文件“/etc/ceph/ceph.conf”中的[global]域中增加rgw_nfs_lru_lane_hiwat配置项,并设置其值为65535,规避问题的发生。

OmniData算子下推限制

- 不支持对事务表的算子下推。

- 不支持对分桶表的算子下推。

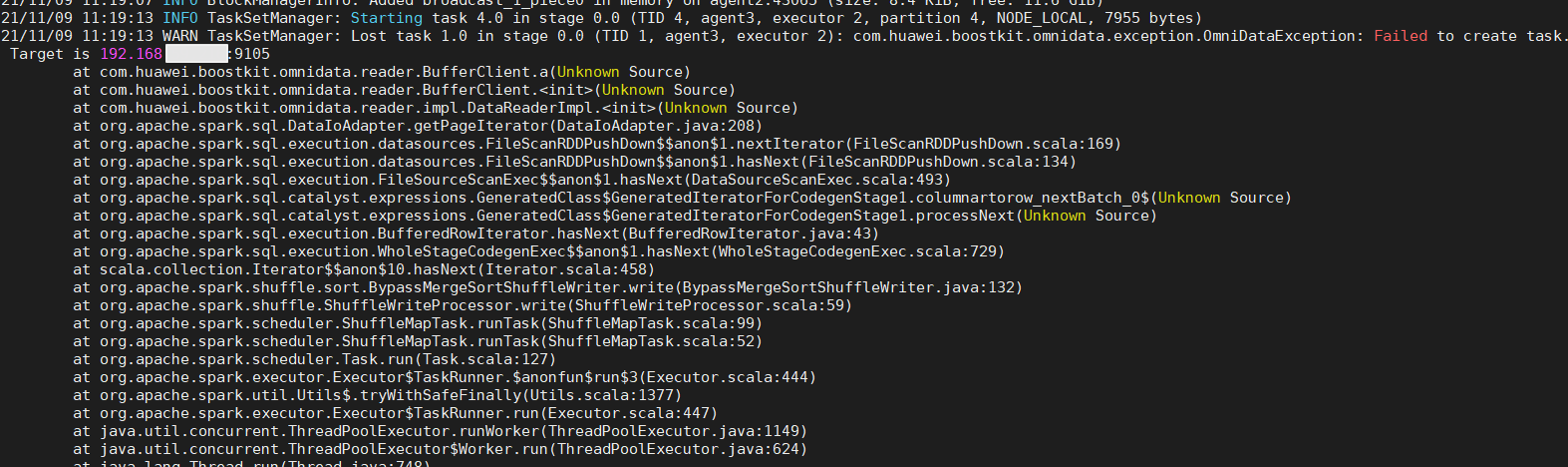

Spark执行报错,HAF日志没有报错

现象描述:

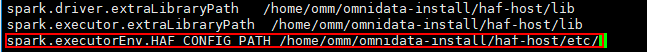

Spark执行报错,HAF日志没有报错,回显信息如下:

Failed to create task.

解决方法:

Spark配置文件中添加spark.executorEnv.HAF_CONFIG_PATH path,其中path为HAF主机节点安装路径下的“etc/”目录。

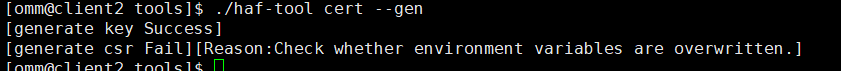

使用haf-tool生成证书时,偶现的生成错误问题

现象描述:

使用haf-tool生成证书时,偶现的生成错误问题,错误信息如下:

/home/omm/omnidata-install/haf-host/tools/scripts/csr_gen_host.sh generate host csr failed

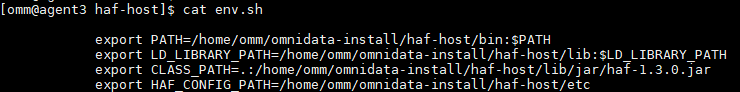

解决方法:

该错误一般是在启动OmniData算子下推时,已经source了如下的主机节点脚本,导致运行时和本地的OpenSSL命令版本冲突,在执行上述证书生成命令时,重新开启一个Shell即可。

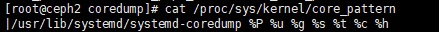

HAF运行时发生系统异常,找不到core文件

现象描述:

HAF框架运行时,发生异常导致进程退出,无法找到coredump文件。

解决方法:

core文件由系统产生,HAF没有权限进行修改,建议查看系统配置文件,确认coredump文件的生成位置。

cat /proc/sys/kernel/core_pattern

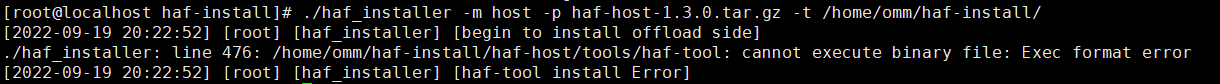

HAF在X86环境安装失败并报错

现象描述:

HAF在X86环境中安装出现错误,提示cannot execute binary file: Exec format error。

解决方法:

HAF不支持在X86环境中安装,请替换为鲲鹏。

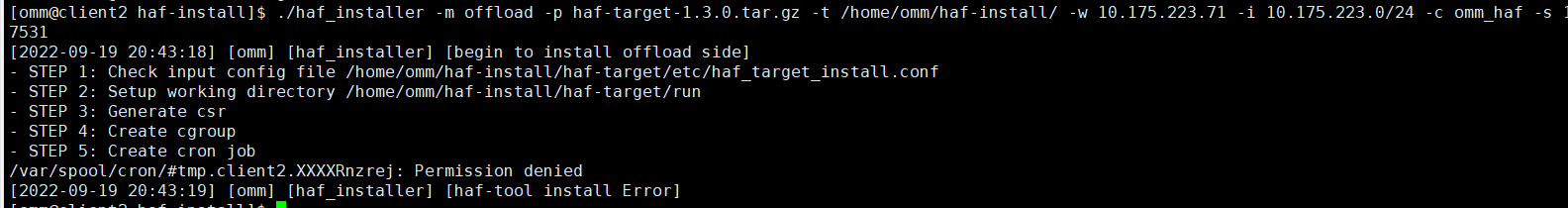

HAF安装crontab权限问题

现象描述:

安装卸载节点时报错,提示/var/spool/cron/#tmp.client2.XXXXOINOX2: Permission denied。

解决方法:

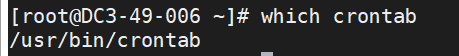

- 找到crontab文件位置。

which crontab

- crontab增加s位,并修改crontab为root所属。

chown root:root /usr/bin/crontab chmod u+s /usr/bin/crontab

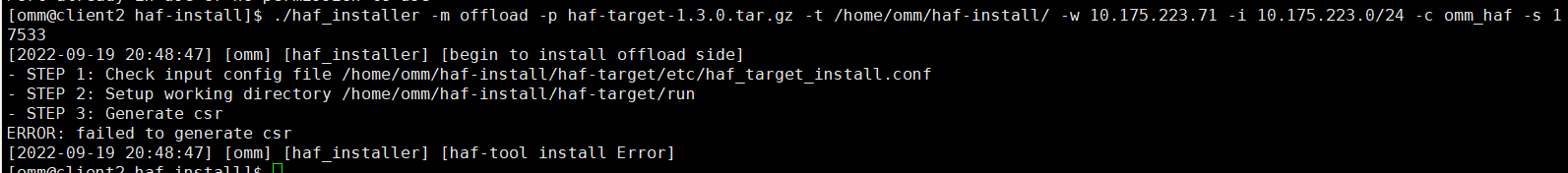

HAF安装系统变量问题

现象描述:

安装卸载节点时报错,提示failed to generate csr。

原因分析:

系统中自带的OpenSSL库被HAF的libssl.so.1.1替换掉了,导致OpenSSL运行出错。

解决方法:

检查“/etc/profile”中环境变量,是否将HAF目录下.so文件导入到系统环境变量中,如果导入,删除即可。

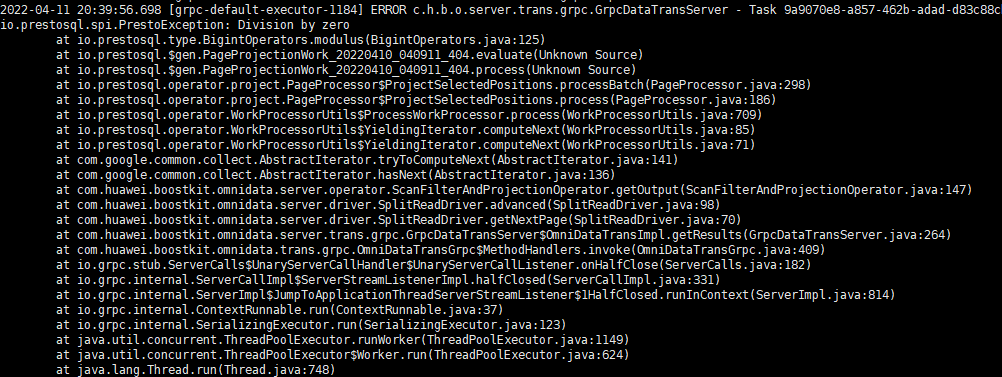

当SQL里面存在除数为0时报错

现象描述:

“select max(o_bigint%o_int) from tpch_flat_orc_date_100.data_type_test_orc;”该sql在下推的Hive中返回为NULL,报错信息为:io.prestosql.spi.PrestoException: Division by zero。

解决方法:

两种引擎的运算处理机制不同。虽然原生Hive有结果,但是返回的结果也是不正确的。对于该现象,无需关注,不影响Hive运行。

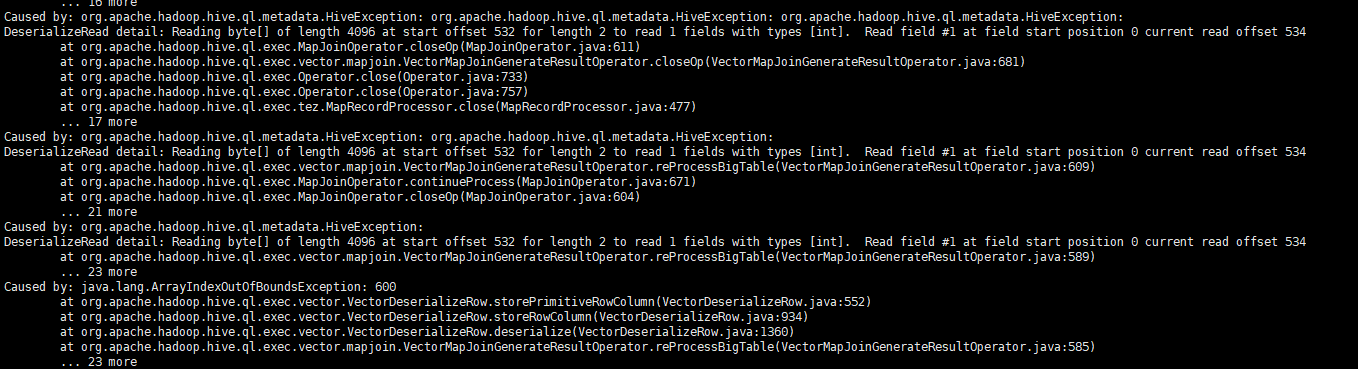

TPCDS分区表SQL5、13、25、62、88和99报错

现象描述:

TPCDS分区表SQL5、13、25、62、88和99报错,报错信息为:DeserializeRead detail: Reading byte[] of length 4096 at start offset 532 for length 2 to read 1 fields with types [int]. Read field #1 at field start position 0 current read offset 534

解决办法:

- 在Hive的配置文件hive-site.xml中加入以下参数:

<property> <name>hive.mapjoin.hybridgrace.hashtable</name> <value>false</value> </property> <property> <name>hive.vectorized.execution.mapjoin.native.fast.hashtable.enabled</name> <value>true</value> </property> - 使用set命令:

set hive.mapjoin.hybridgrace.hashtable=false; set hive.vectorized.execution.mapjoin.native.fast.hashtable.enabled=true;