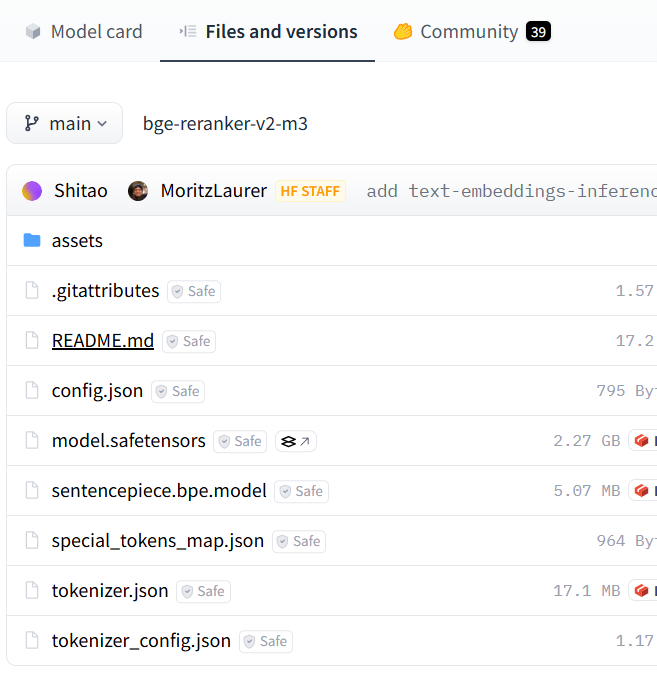

- 下载Rerank模型。

访问HuggingFace网站获取所需模型:https://huggingface.co/BAAI/bge-reranker-v2-m3/tree/main。

以BAAI/bge-reranker-v2-m3为例,下载“Files and versions”下所有文件。

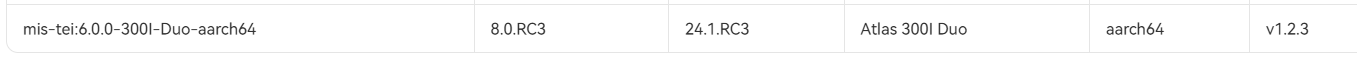

- 下载mis-tei镜像。

访问链接https://www.hiascend.com/developer/ascendhub/detail/07a016975cc341f3a5ae131f2b52399d,根据NPU类型下载相应镜像。

- 运行容器。

docker run -u root -e ASCEND_VISIBLE_DEVICES=1 -itd --name=tei_r --net=host \ -e HOME=/home/HwHiAiUser \ -e TEI_NPU_DEVICE=0 \[可选] --privileged=true \ -v /root/bge-reranker-v2-m3:/home/HwHiAiUser/model/bge-reranker-v2-m3 \ -v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi \ -v /usr/local/Ascend/driver:/usr/local/Ascend/driver \ --entrypoint /home/HwHiAiUser/start.sh \[可选,一般不加] swr.cn-south-1.myhuaweicloud.com/ascendhub/mis-tei:6.0.0-300I-Duo-aarch64 BAAI/bge-reranker-v2-m3 ip port

以下参数用户可根据实际情况进行配置:

- -e ASCEND_VISIBLE_DEVICES=1:指定容器运行至特定的NPU上,此处即为运行至npu_id = 1上。

- -e HOME=/home/HwHiAiUser:设置环境变量HOME的路径。

- -e TEI_NPU_DEVICE=0:指定服务运行至特定的NPU上,此处即为运行至npu_id = 0上。

- --name=tei_r: 指定容器名称。

- -v /root/bge-reranker-v2-m3:/home/HwHiAiUser/model/bge-reranker-v2-m3:宿主机模型文件夹所在位置:容器模型安装位置。注意,容器中一定要存在bge-reranker-v2-m3文件夹,否则在线下载模型,可能引起容器服务化失败。

- swr.cn-south-1.myhuaweicloud.com/ascendhub/mis-tei:6.0.0-300I-Duo-aarch64 BAAI/bge-reranker-v2-m3 ip port

- swr.cn-south-1.myhuaweicloud.com/ascendhub/mis-tei:6.0.0-300I-Duo-aarch64:mis-tei镜像ID。

- BAAI/bge-reranker-v2-m3:从hugging face获取的模型ID。

- ip:用于配置服务化的IP地址。

- port:用于配置服务化端口,不要与其他容器冲突。

后三项为tei服务所需参数,可参考https://github.com/huggingface/text-embeddings-inference中text-embeddings-router --help一栏。

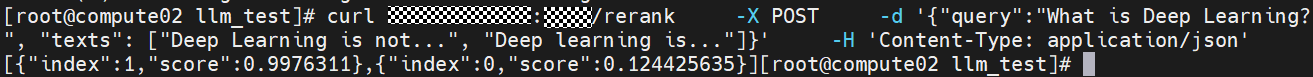

- Rerank模型新建窗口接口测试。

curl ip:port/rerank \ -X POST \ -d '{"query":"What is Deep Learning?", "texts": ["Deep Learning is not...", "Deep learning is..."]}' \ -H 'Content-Type: application/json'