AI+微服务集成

AI服务集成

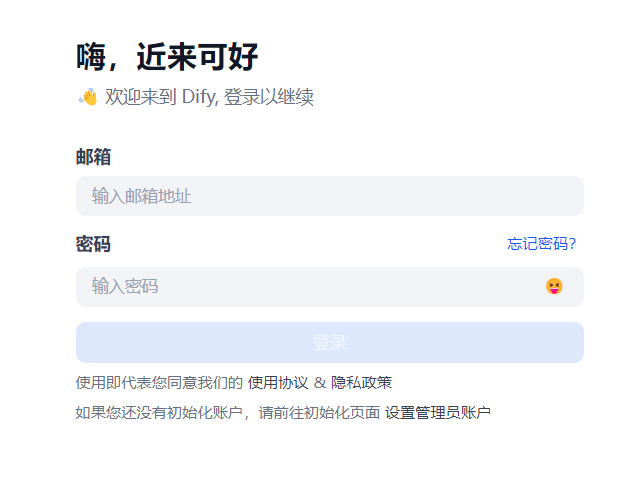

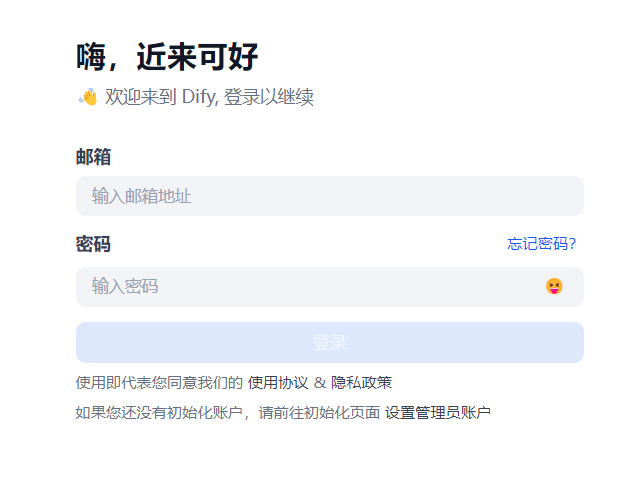

- 访问本地部署的Dify web服务页面。

http://your_server_ip

- 注册管理员账户并登录。

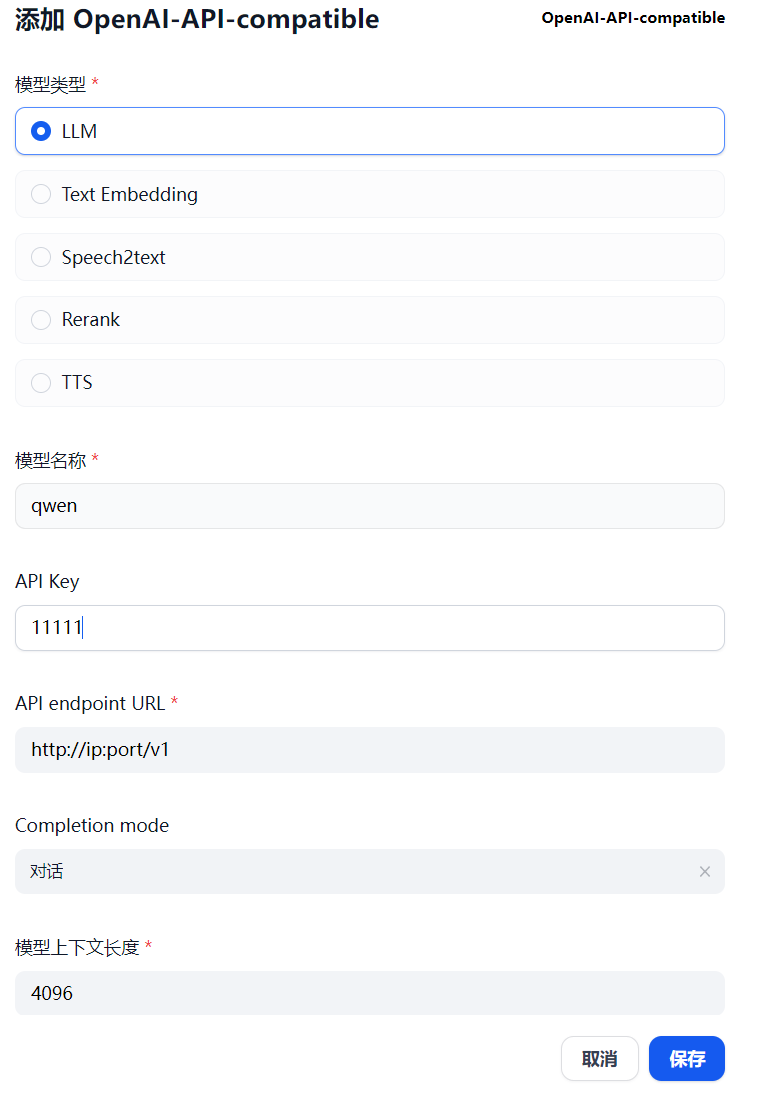

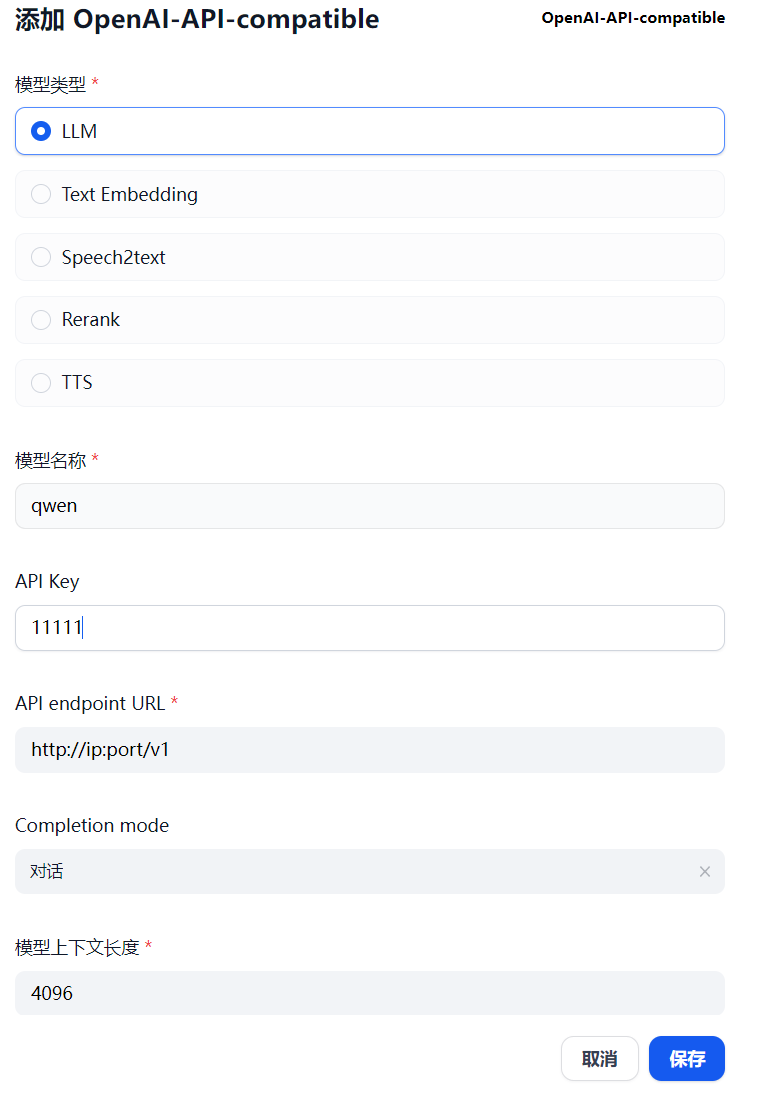

- 接入LLM服务。

- 在主界面单击右上角用户名,然后单击“设置”进入设置页面,单击“模型供应商”,选择“OpenAI-API-compatible”卡片,单击“安装”按钮。

- 安装完成后,在添加模型页面,“模型类型”选择“LLM”。

- 输入“模型名称”(推理服务部署(DeepSeek-R1-Distill-Qwen-7B)中配置的LLM模型名称)。

- “API Key”。若在模型中有设置api-key,需配置为与模型的api-key对应,若没有配置,则不填写即可。

- “API endpoint URL”根据提示,替换成LLM服务的IP地址和端口。

- 可以调整模型上下文长度和最大token上限。

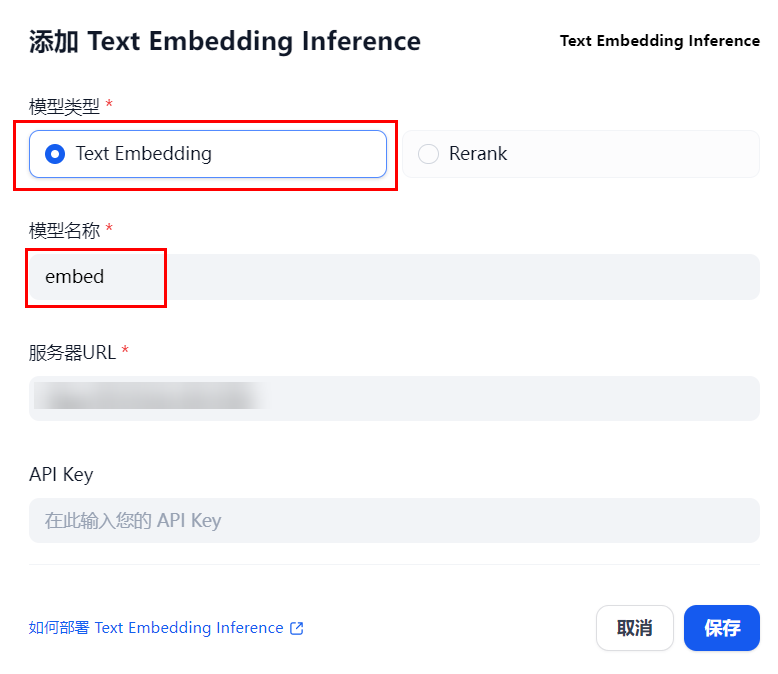

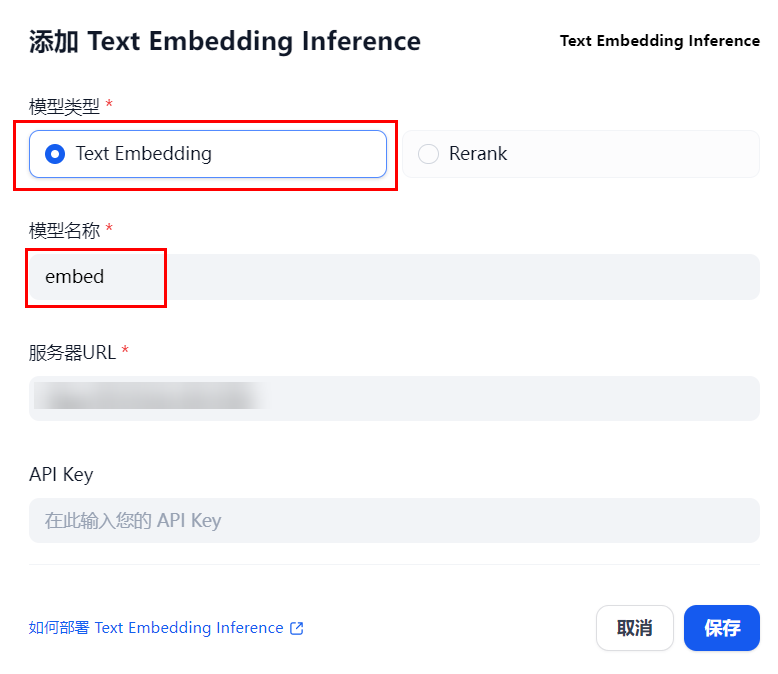

- 接入Embedding/Rerank服务。

- 在设置页面,单击“模型供应商”,选择“Hugging Face Hub”卡片,单击“安装”按钮。

- 安装完成后,在添加模型页面,“模型类型”选择“Text Embedding”或者“Rerank”。

- 输入“模型名称”为“embed”或者“rerank”。

- “服务器URL”根据提示,替换成Embedding/Rerank服务的IP地址和端口。

- “API Key”填写为与模型的api-key对应的值,若没有配置,则不填写即可。

- 重复3,模型类型分别选择Text Embedding或Rerank,然后单击“保存”。