AI+微服务集成

AI服务集成

- 访问本地部署的RAGFlow web服务页面。

http://your_server_ip

- 首次登录请注册账户,注册完成后输入邮箱和密码完成登录。

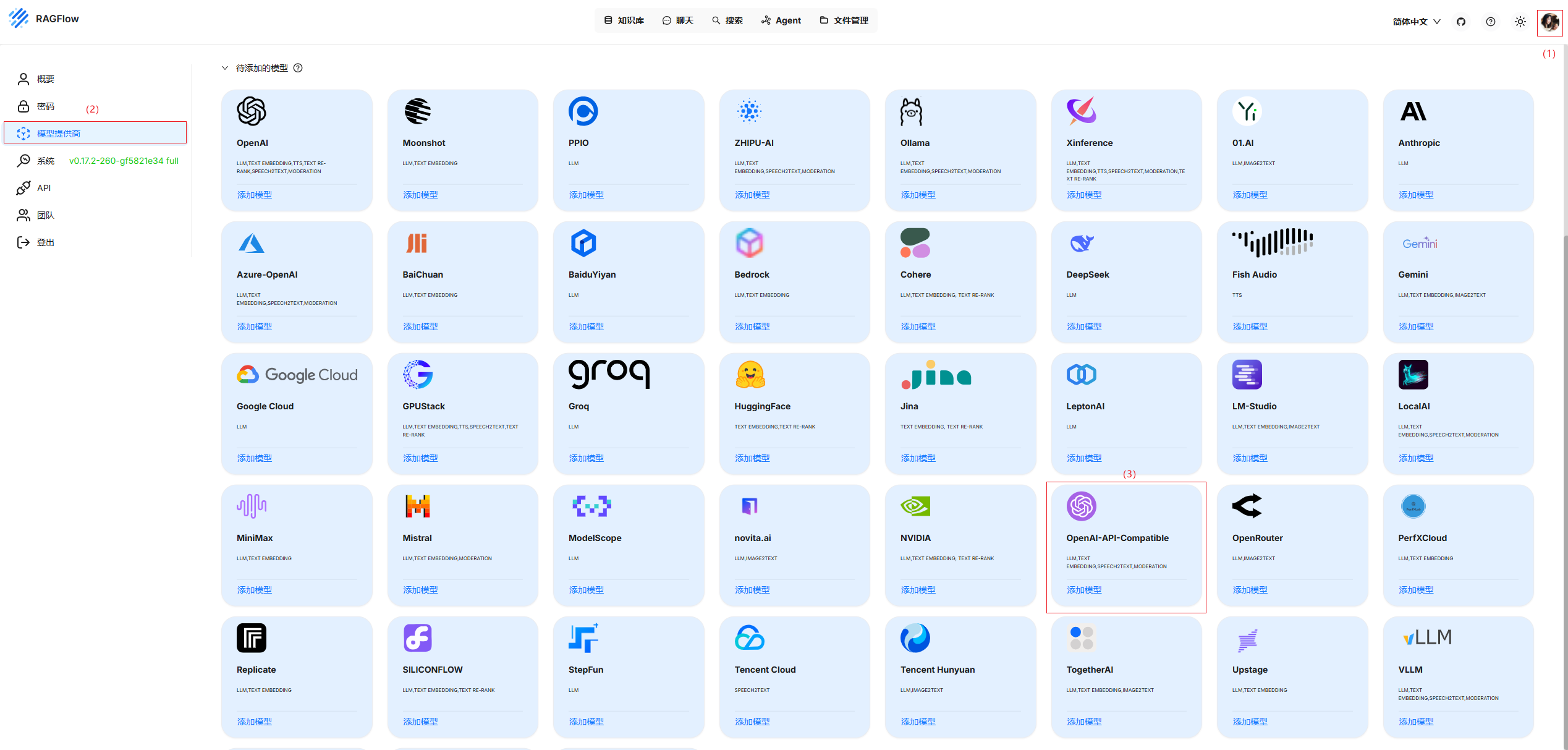

- 接入LLM服务。

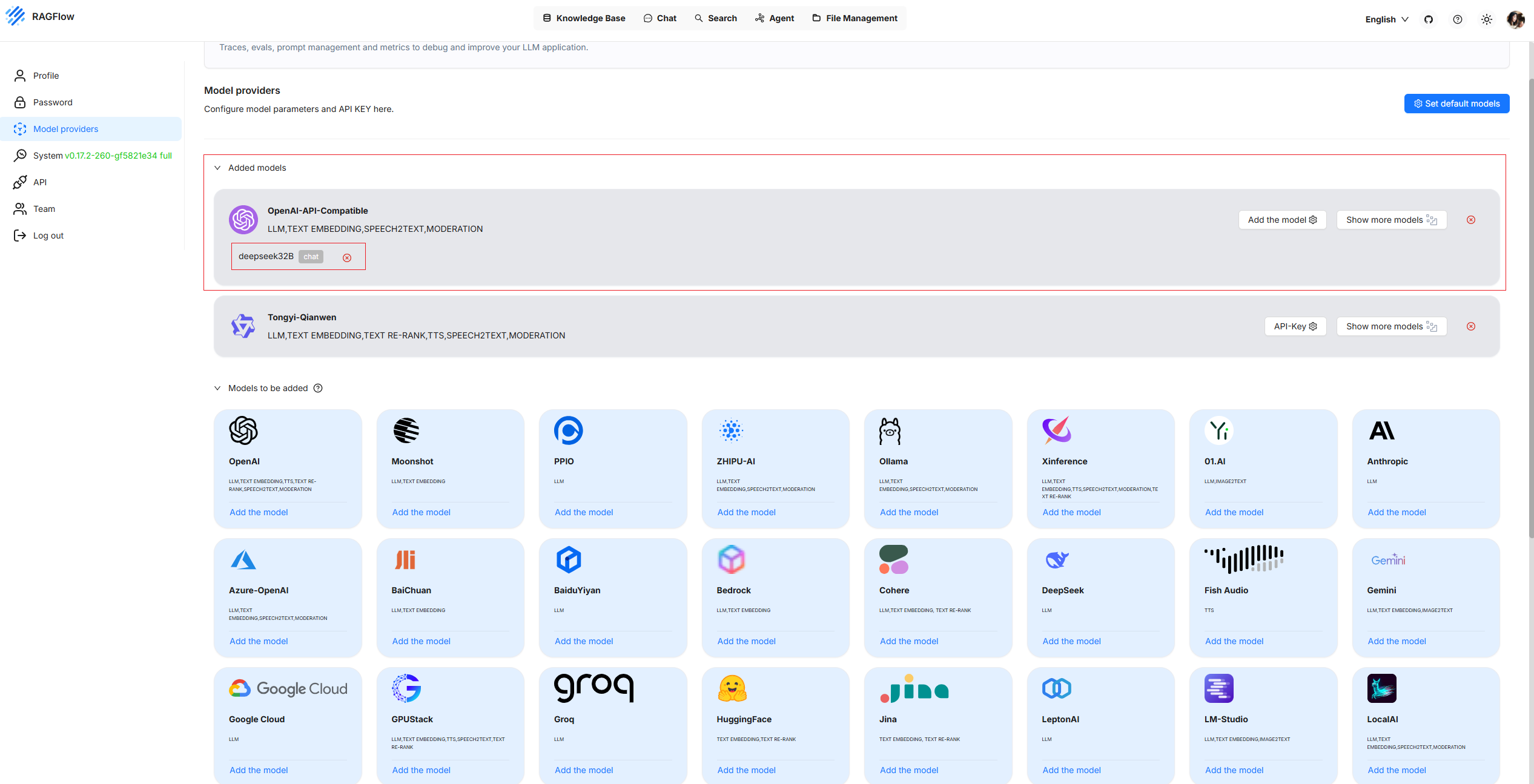

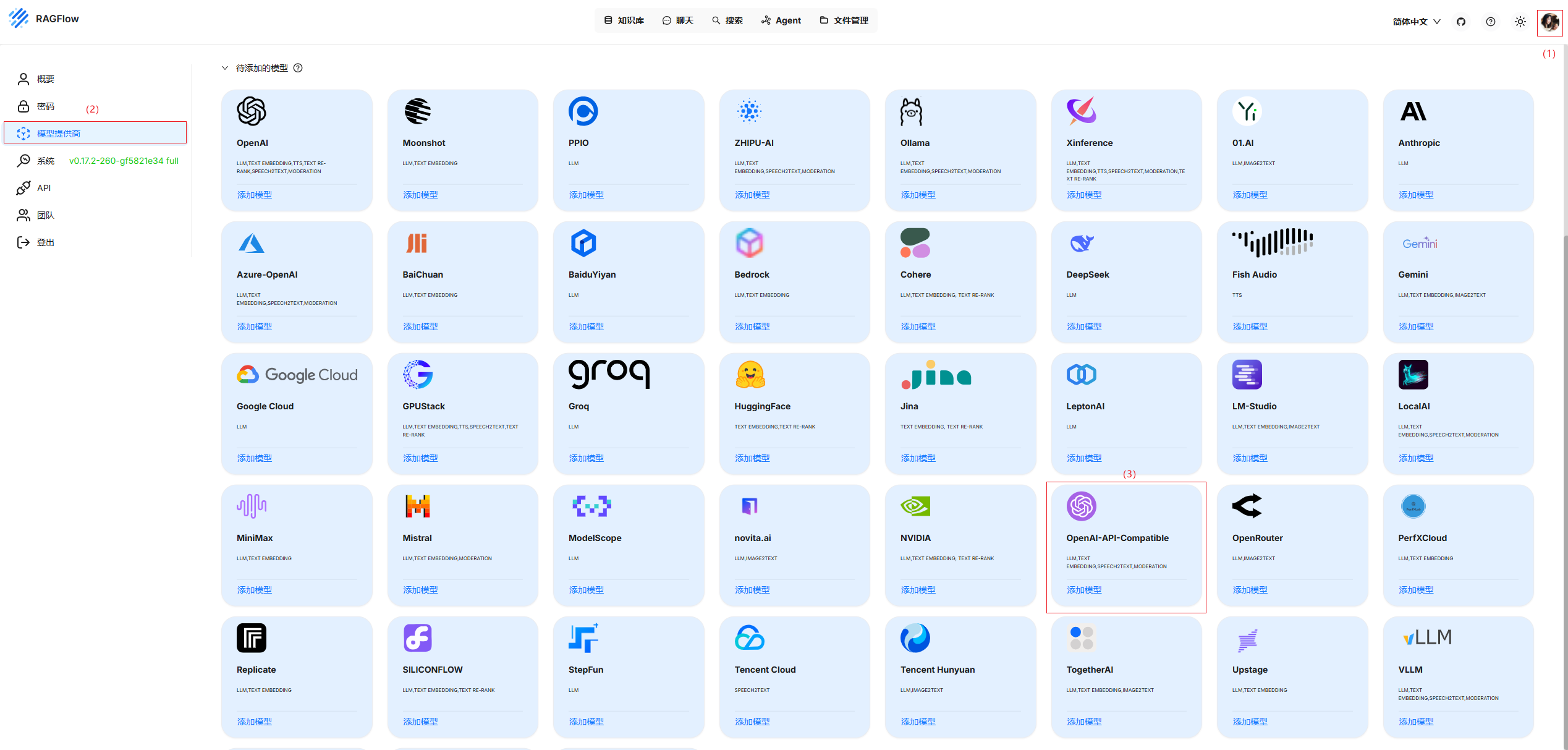

- 在主界面单击右上角用户头像,然后单击“模型提供商”进入模型提供商安装界面,选择“OpenAI-API-compatible”卡片,单击“Add the model”按钮。

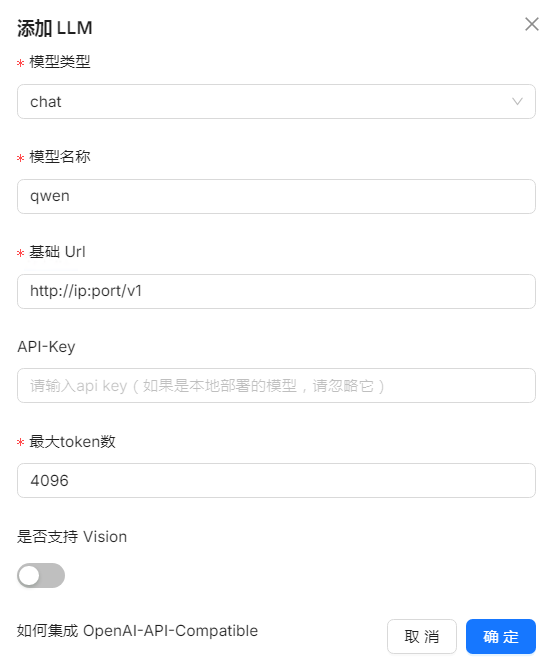

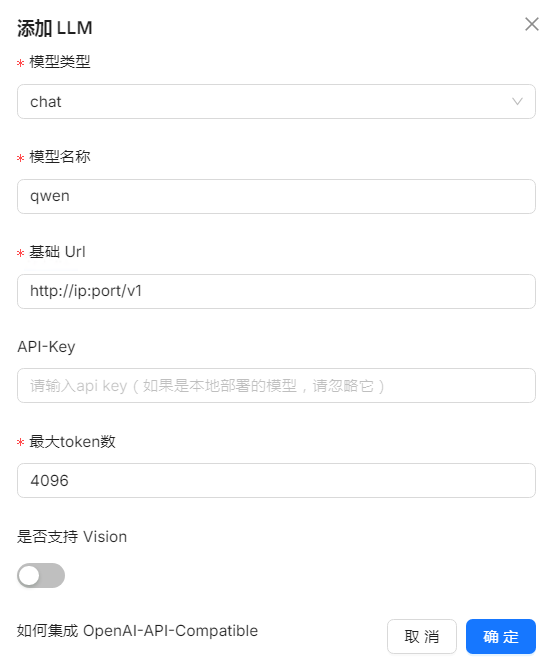

- 在添加模型页面,配置LLM模型信息。“Model type”选择“chat”类型;“Model name”填写(推理服务部署(DeepSeek-R1-Distill-Qwen-7B)中配置的LLM模型名称);“API Key”填写为与模型的api-key对应的值,若没有配置,则不填写即可;“Base url”填写已部署的LLM服务的IP地址和端口;“Max Tokens”可以调整模型输出的最大长度。

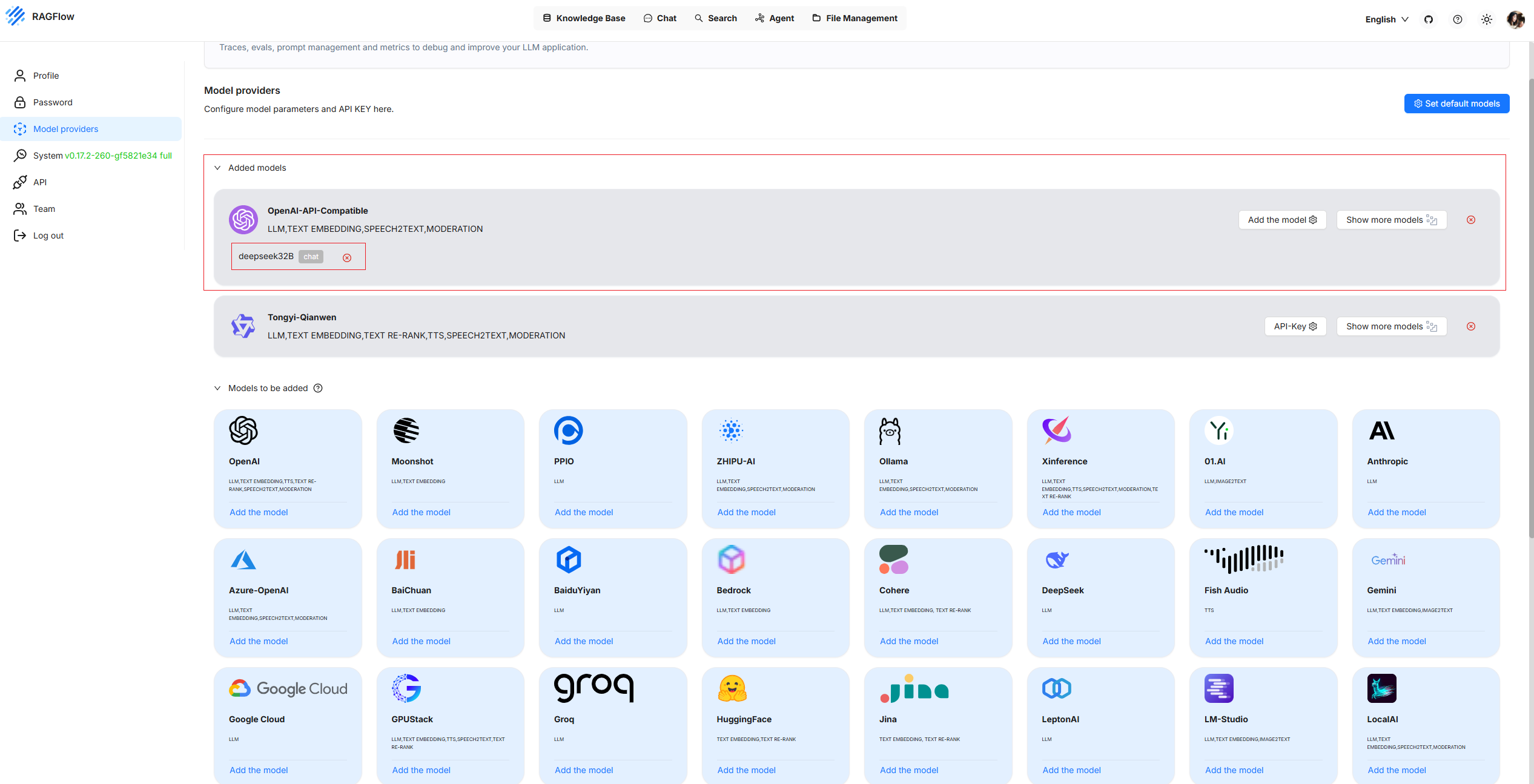

- 单击“确定”,等待连接LLM模型成果后,在已添加模型中可以查看到已接入的LLM模型。

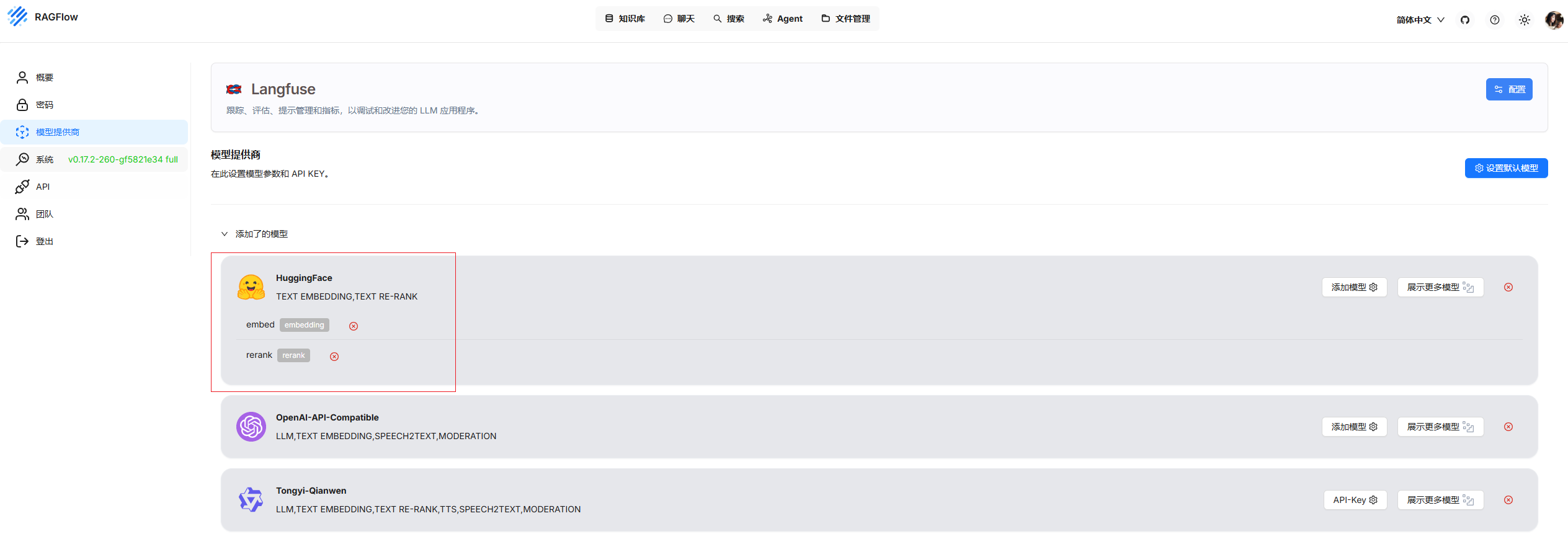

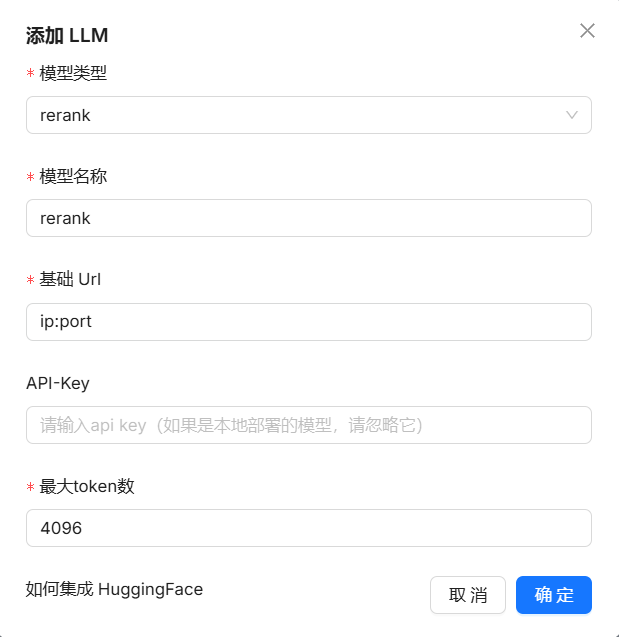

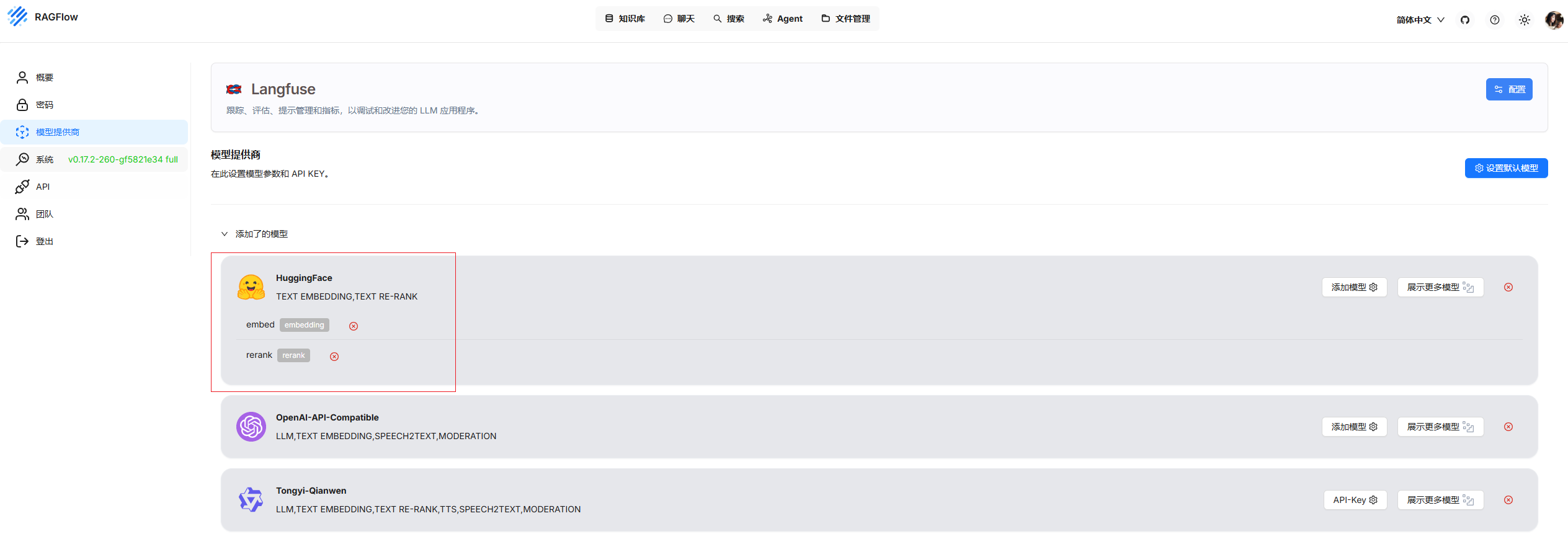

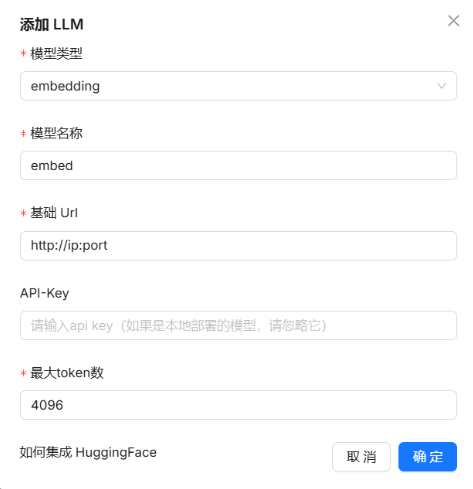

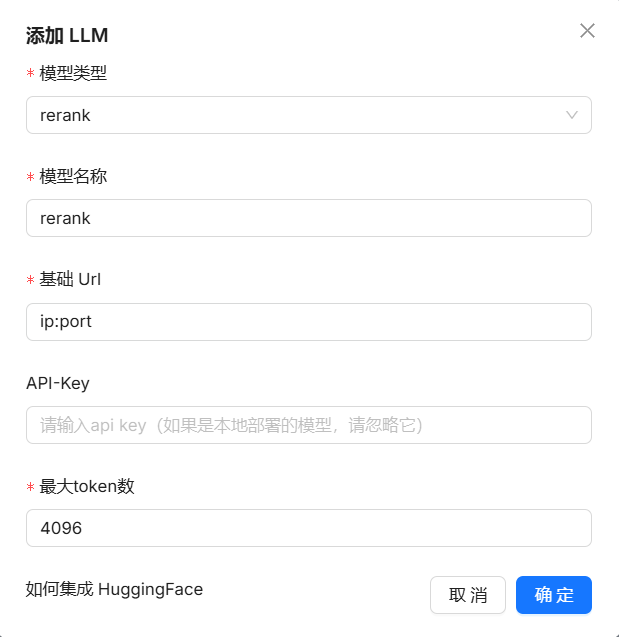

- 接入Embedding/Rerank服务。

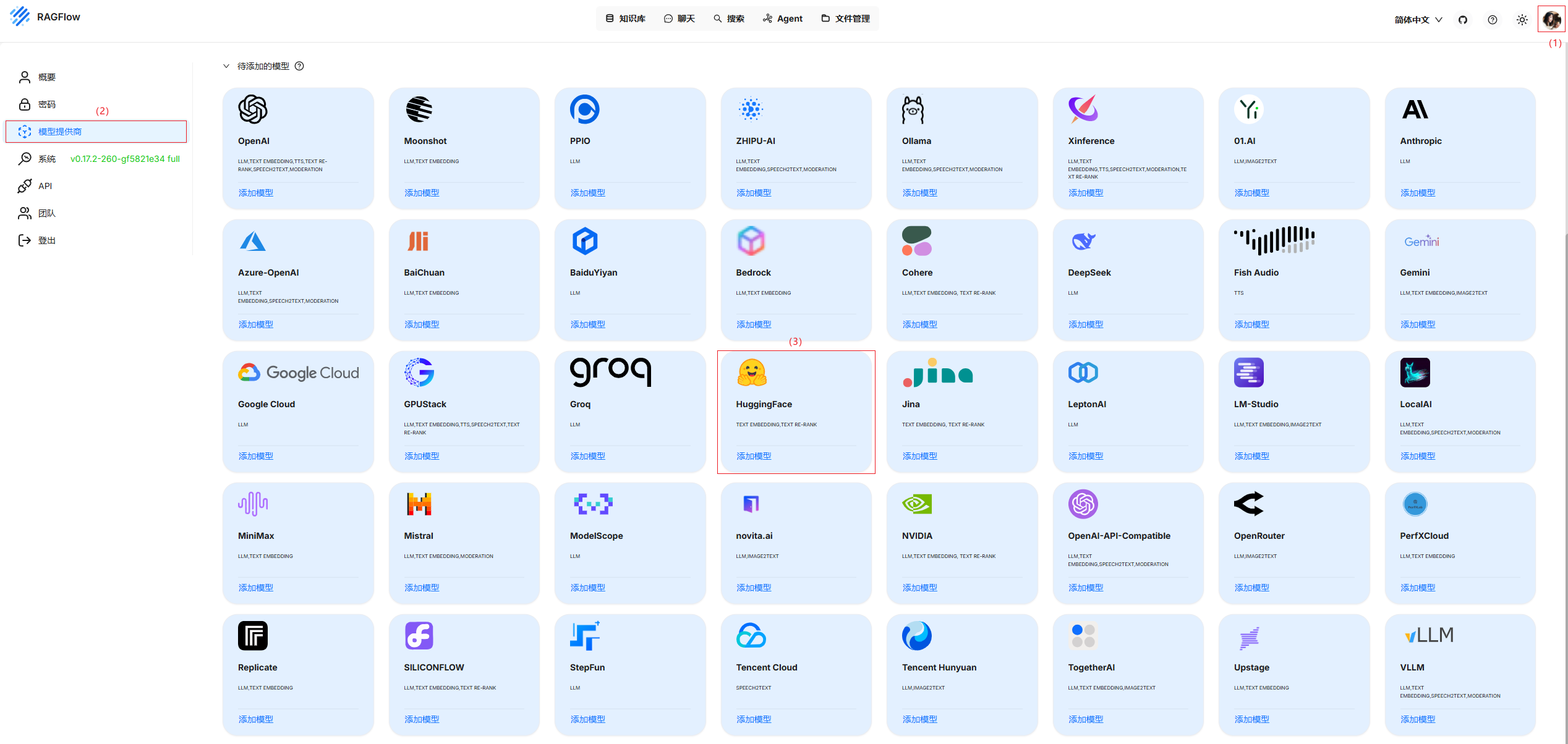

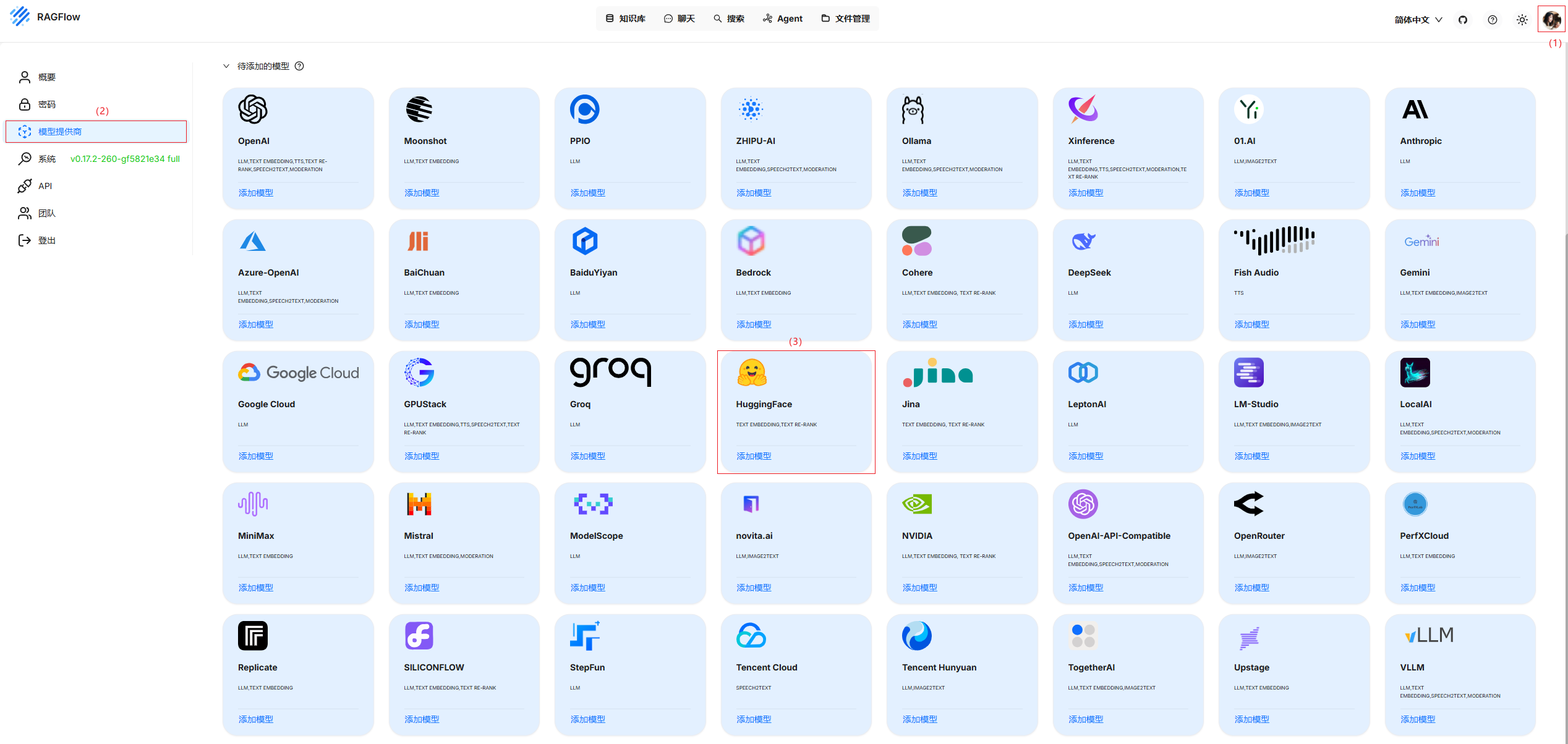

- 在主界面单击右上角用户头像,然后单击“Model providers”进入模型提供商安装界面,选择“HuggingFace”卡片,单击“Add the model”按钮。

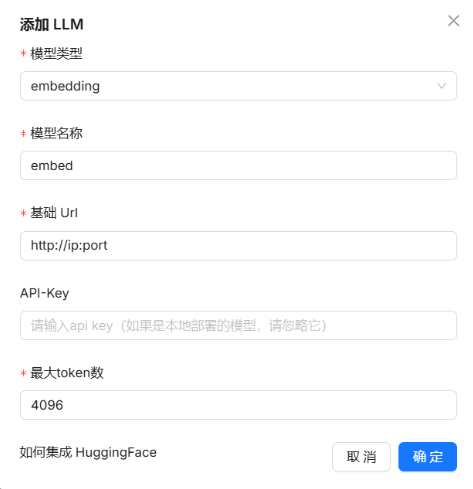

- 在添加模型页面,配置模型信息。“Model type”选择“embedding”或“rerank”类型;“Model name”填写“embed”或“rerank”;“API Key”填写为与模型的api-key对应的值,若没有配置,则不填写即可;“Base url”填写已部署的LLM服务的IP地址和端口;“Max Tokens”可以调整模型输出的最大长度。

- 单击“确定”,等待连接embedding或rerank模型成功后,在已添加模型中可以查看到已接入的模型。