开启oneDNN/ACL加速

oneDNN/ACL加速会启用oneDNN、ACL作为PyTorch的后端计算库,为深度学习等任务提供最佳性能,若您需要此加速功能请参照本节内容进行安装。安装过程中请根据实际情况替换安装路径。

- 获取ACL源码。

- 解压ACL源码包。

1tar -xzvf v23.08.tar.gz

- 进入“/path/to/ComputeLibrary-23.08”目录。

1cd /path/to/ComputeLibrary-23.08

- scons构建。

1scons Werror=1 -j8 debug=0 neon=1 opencl=0 os=linux arch=armv8a build=native

- 设置ACL环境变量。

1export ACL_ROOT_DIR=/path/to/ComputeLibrary-23.08

- 验证。

- 进入“build”目录。

1cd build

- 设置ACL动态库的环境变量。

1export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/path/to/ComputeLibrary-23.08/build/

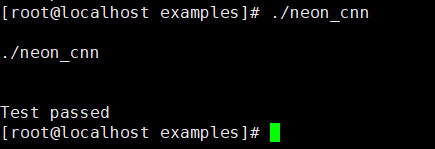

- 执行example用例。

1./examples/neon_cnn

- 进入“build”目录。

- (可选)如果安装过PyTorch,需要先清理旧的编译文件。

- 进入“/path/to/pytorch”目录。

1cd /path/to/pytorch

- 删除构建目录。

1rm -rf ./build

- 进入“/path/to/pytorch”目录。

- 请参见基本安装安装PyTorch,其中,步骤5环境变量增加以下几项:

1 2

export USE_MKLDNN=1 export USE_MKLDNN_ACL=1

USE_MKLDNN:设置为1,表示启用oneDNN库优化推理计算。

USE_MKLDNN_ACL:设置为1,表示在启用USE_MKLDNN的基础上启用ACL的能力。

- 安装检查。

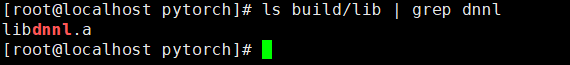

- 检查目录是否包含oneDNN的静态库文件。

1ls build/lib | grep dnnl

结果如下图所示则表示包含了oneDNN静态库文件。

- 检查libtorch.so的软连接是否包含ACL库的so文件。

1ldd build/lib/libtorch.so | grep compute

结果如下所示则表示包含了ACL库的so文件。1 2 3

libarm_compute.so => /path/to/ComputeLibrary-23.08/build/libarm_compute.so (0x0000ffff9ca99000) libarm_compute_graph.so => /path/to/ComputeLibrary-23.08/build/libarm_compute_graph.so (0x0000ffff9c9b7000) libarm_compute_core.so => /path/to/ComputeLibrary-23.08/build/libarm_compute_core.so (0x0000ffff9c996000)

- 检查目录是否包含oneDNN的静态库文件。

父主题: 源码编译安装