Ceph部署

- 安装Ceph软件并部署MON、MGR节点。

- 部署OSD节点。

操作前请确认哪些硬盘作为数据盘使用,并确保数据盘中没有未清理的分区。若存在未清理分区,需先进行清除。

- 查看各硬盘下是否有分区。

1lsblk

- 若存在分区信息,则清除分区信息(以盘符/dev/sdb为例)。

1ceph-volume lvm zap /dev/sdb --destroy

- 在Ceph-Node 1上创建脚本create_osd.sh,将每台服务器上的12块Bcache盘作为OSD的数据盘。

1 2

cd /etc/ceph vi /etc/ceph/create_osd.sh

添加以下内容:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22

#!/bin/bash for node in ceph1 ceph2 ceph3 do j=7 k=1 for i in `ssh ${node} "ls /sys/block | grep bcache | head -n 6"` do ceph-deploy osd create ${node} --data /dev/${i} --block-wal /dev/nvme0n1p${j} --block-db /dev/nvme0n1p${k} ((j=${j}+1)) ((k=${k}+1)) sleep 3 done j=7 k=1 for i in `ssh ${node} "ls /sys/block | grep bcache | tail -n 6"` do ceph-deploy osd create ${node} --data /dev/${i} --block-wal /dev/nvme1n1p${j} --block-db /dev/nvme1n1p${k} ((j=${j}+1)) ((k=${k}+1)) sleep 3 done done

- 此脚本内容只适用于当前硬件配置,其他硬件配置可参考此脚本。

- ceph-deploy osd create命令中:

- ${node}是节点的hostname。

- --data选项后面是作为数据盘的设备,以Bcache的后端盘作为数据盘。

- --block-db选项后面是DB分区。

- --block-wal选项后面是WAL分区。

- DB和WAL通常部署在NVMe SSD上以提高写入性能,如果没有配置NVMe SSD或者直接使用NVMe SSD作为数据盘,则不需要和--block-wal,只需要加--data指定数据盘即可。

- 在ceph1上运行脚本。

1bash create_osd.sh - 创建成功后,查看OSD是否创建成功。

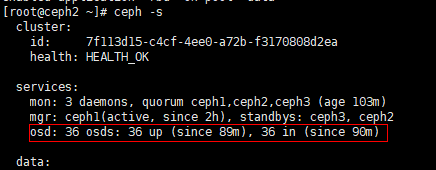

ceph -s

36个OSD都为up即为创建成功。

- 查看各硬盘下是否有分区。

父主题: Ceph使能IO智能预取